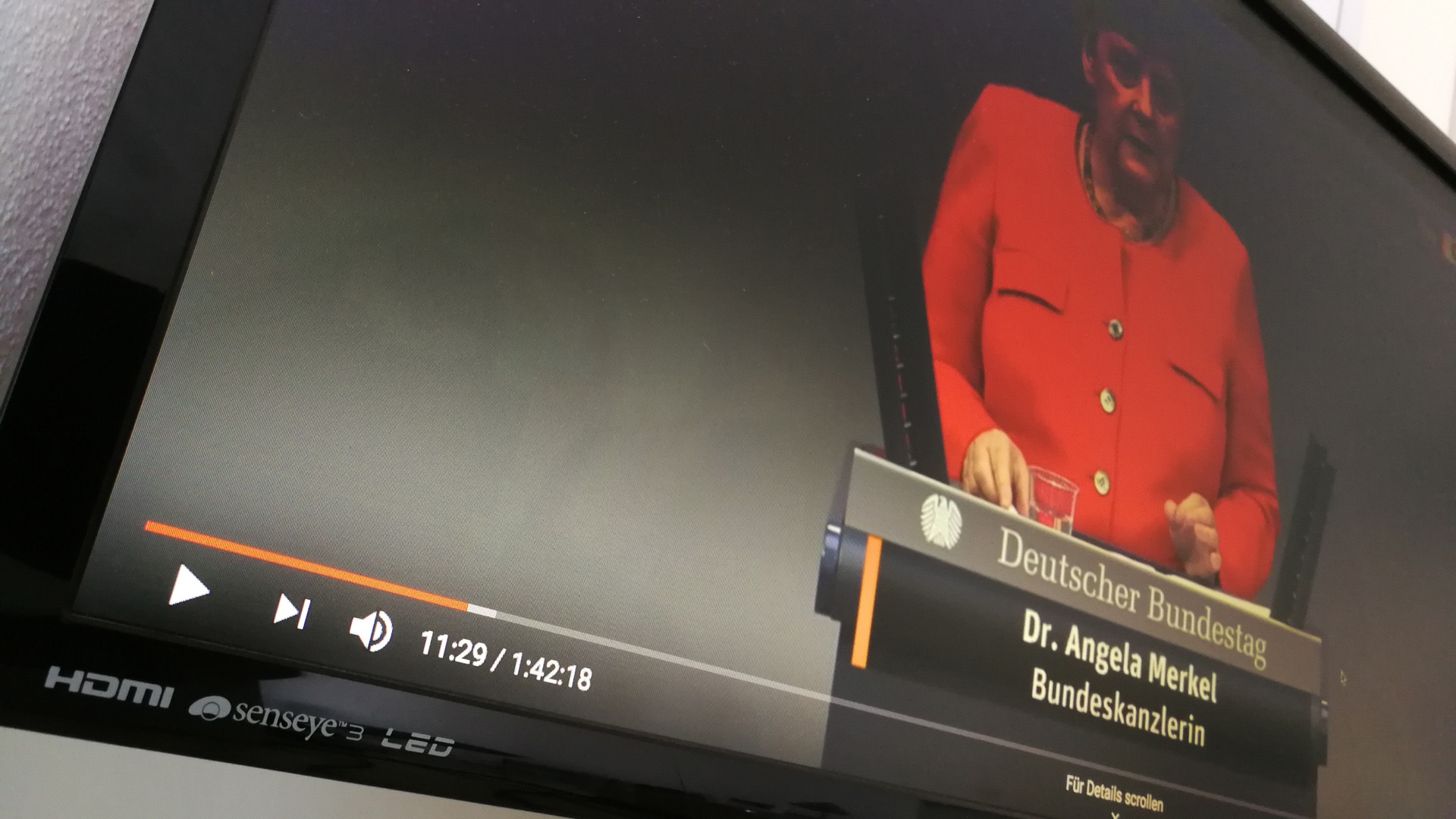

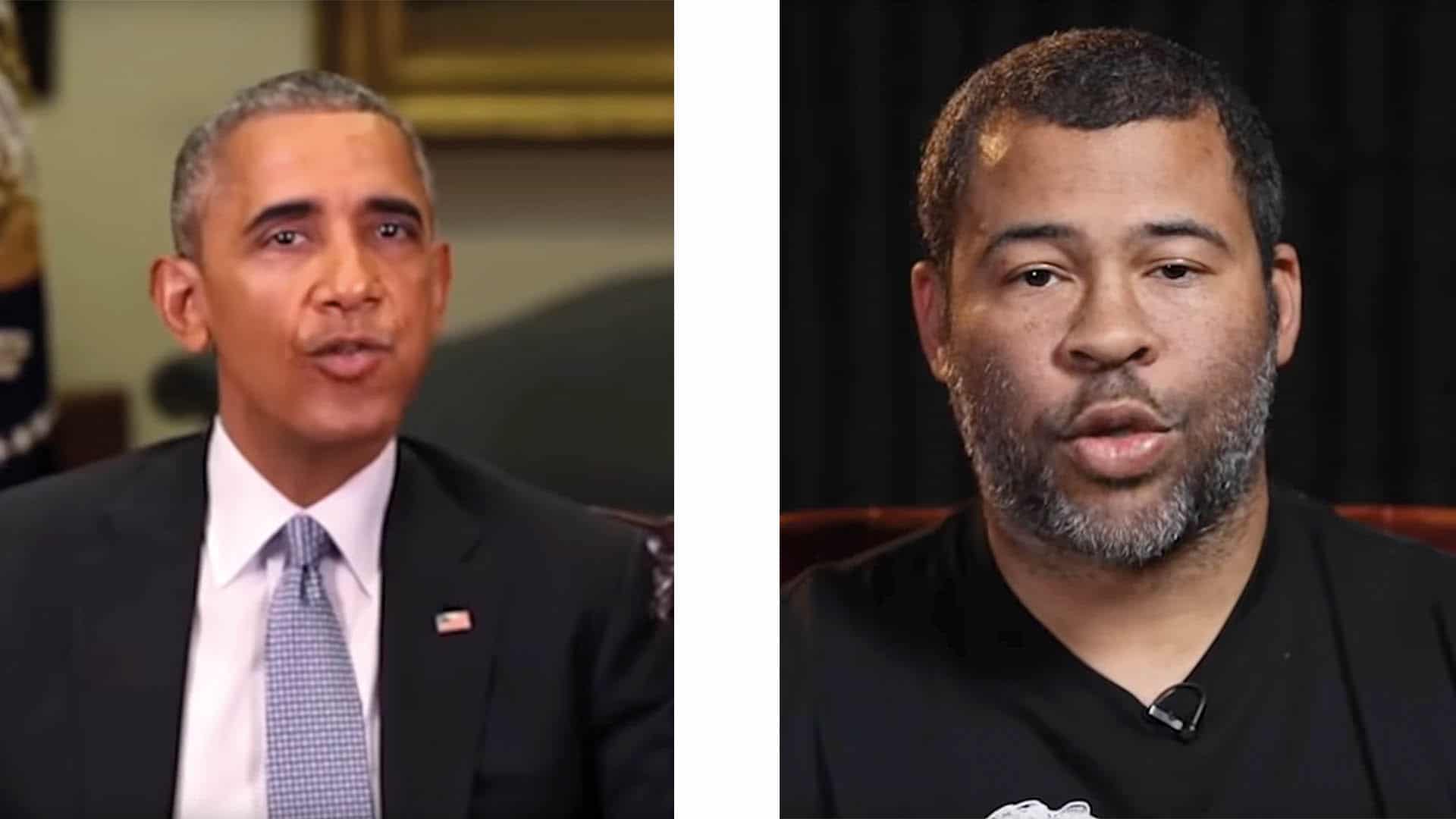

Eine aktuelle Studie der Konrad-Adenauer-Stiftung in Zusammenarbeit mit dem Counter Extremism Project untersucht das Gefahrenpotential von Deep Fakes für Demokratien und Gesellschaften. Bei Deep Fakes handelt es sich um technisch erzeugte Video-Fälschungen, in denen Gesichter und Stimmen beliebiger Personen täuschend echt simuliert werden können.

Mit dieser frei verfügbaren Technologie kommen laut der Studie große Gefahren auf Demokratien und Gesellschaften zu – gerade wenn sie in gezielten Desinformationskampagnen über Soziale Medien eingesetzt wird. Dort könnten gefälschte Videos mit Falschinformationen in kurzer Zeit große Teile der Bevölkerung erreichen. Staaten oder Einzelpersonen könnten damit Wahlen beeinflussen oder Unruhe in der Gesellschaft fördern.

Momentan könnten Fälschungen noch relativ leicht erkannt werden. Wie die Studie mit Beispielen in politischen Kontexten zeigt, hätten Nutzer in den Sozialen Netzwerken manipulierte Videos trotz ihrer geringen technischen Qualität als echt eingestuft und geteilt. So seien Deep Fakes beispielsweise vor den britischen Parlamentswahlen strategisch eingesetzt worden, um die Wahlaussichten prominenter Politiker zu verringern.

Diese Gefahr steige weiter, weil sich die technischen Möglichkeiten verbesserten. Dies führe einerseits zu geringeren technischen Anforderungen, um gefälschte Videos zu produzieren, andererseits steige die Qualität und damit die vermeintliche Echtheit. Fälschungen seien immer schwerer zu erkennen. Gerade „klassischen“ politischen Desinformationskampagnen, die beispielsweise mit Falschmeldungen arbeiteten, könnten vermeintlich echte Videos zusätzliche Glaubwürdigkeit verleihen. Die Studie verweist auf die Nachrichtendienstgemeinschaft der Vereinigten Staaten, die schon 2019 Deep Fakes als eine der größten globalen Bedrohungen eingestuft habe.

Strategie für die Politik

Um Gesellschaft und Demokratie vor den schädlichen Auswirkungen von Deep Fakes auf Information und Meinungsbildung zu schützen, schlagen die Autoren eine dreiteilige Strategie vor. Sie umfasst zunächst, die Rechtslage so anzupassen, dass sie klar zwischen legalem und illegalem Gebrauch der Technologie unterscheidet. Ein legaler Kontext sei beispielsweise die Nutzung in Bereichen der Satire, Kunst oder politischer Kritik. Illegale sei die Anwendung dann, wenn es um Betrugsversuche oder die Erstellung von nicht einvernehmlicher Pornographie gehe, bei der die Gesichter von unbeteiligten Personen in Porno-Videos eingefügt werden. Das ist bereits strafbar. Aber auch politische Falschmeldungen und Desinformationskampagnen müssten durch Gesetzesanpassungen strafrechtlich verfolgbar gemacht werden, fordern die Autoren der Studie.

Der technische Teil der Strategie hat zwei Ziele: Zertifikate für authentische Videos und technisch gestützte, zweifelsfreie Identifikation von manipulierten Videos. Die Öffentlichkeit aufzuklären und ihre Kompetenz im Umgang mit Deep Fakes zu steigern, gerade auch in Sozialen Medien, ist die dritte Empfehlung der Studie. Eine politische Debatte über geeignete Abwermaßnahmen sei dringend nötig.

Von: Immanuel Dobrowolski