Als vor zwei Jahren der deutsche Wissenschaftler Matthias Niessner von der Stanford Universität zu Gast in der Unterhaltungsshow des Moderators Jimmy Kimmel war, staunte das Publikum nicht schlecht, als er seine Arbeit präsentierte. Gastgeber Kimmel sprach in die Kamera, und in Echtzeit bewegte sich auf einem anderen Bildschirm zu seinen Mundbewegungen das Gesicht einer prominenten Person. Es war, als könne der verblüffte Moderator mit seinem Gesicht das eines anderen Menschen fernsteuern. Es sah tatsächlich so aus, als würde der Boxer Mike Tyson ein paar Worte mit einer fremden Stimme an das Publikum richten.

Niessner ist Teil eines achtköpfigen Forscherteams aus Deutschland, Frankreich und den USA. Beteiligt sind die Universität Erlangen-Nürnberg, das Max-Planck-Institut und die Stanford University. Ihre neu entwickelte Software mit dem Namen „Face2face“ erlaubt es, eine Fake-Version des Gesichtes einer anderen Person zu bewegen. Mund, Gesichtszüge und Augenbrauen bewegen sich beim „geklauten“ Gesicht genau so, wie die Person, die in Wirklichkeit spricht. Sogar die Kopfbewegungen macht der virtuelle Zwilling mit. Das ist alles nicht perfekt, aber es reicht aus, um viele Menschen zu täuschen. Wie sicher können wir noch sein, wenn wir uns Beiträge im Fernsehen anschauen oder Videos im Internet sehen und glauben, es handele sich um Nachrichten?

Die Entwickler von „Face2face“ können im Grunde die Gesichtszüge jeder beliebigen Person auf jede andere Person übertragen. Das macht natürlich besonders Spaß bei Prominenten, wenn es um eine Unterhaltungsshow geht. Es kann aber genauso gut schnell ernst werden, wenn Menschen getäuscht werden sollen. Dann glauben eventuell viele Millionen Wähler oder andere wichtige Entscheidungsträger, dass dieser oder jener Politiker etwas gesagt hat, obwohl das nie so passiert ist.

Alles, was die Programmierer benötigen, ist ein rund 20 Sekunden langes Video einer Person, etwa auf YouTube. Daraus bastelt ihr Algorithmus eine Sammlung an Gesichtsausdrücken, die dann nur noch mit den entsprechenden Wort-Äußerungen oder mit der restlichen Mimik verknüpft werden müssen.

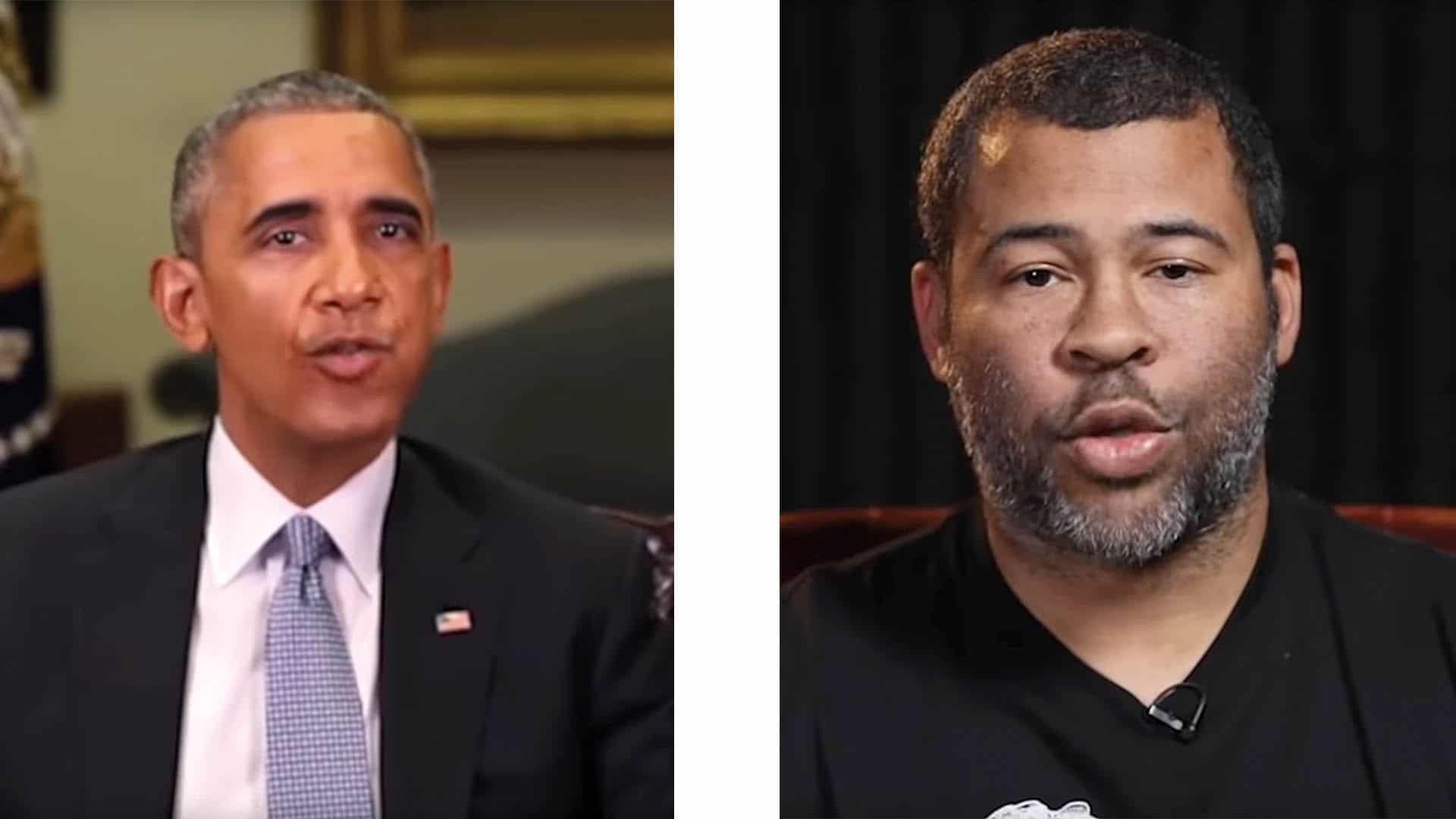

Der Comedian Peele nutzte die neue Technik, um mit dem Gesicht Obamas gleich vor deren Missbrauch zu warnen. „Wir sind in eine Ära eingetreten, in der unsere Feinde es so aussehen lassen können, als könne jeder jederzeit alles sagen. Selbst wenn sie das so nie sagen würden“, sagt der gefakte Obama. Peeles Vorteil ist, dass er auch die Stimme des ehemaligen Präsidenten verblüffend echt nachmachen kann. Wüsste man also nichts von „Face2Face“, könnte man wirklich annehmen, man sähe eine Aufnahme Obamas. Der unechte Obama sagt weiter: „Sie können mich Dinge sagen lassen wie ‚Präsident Trump ist ein Vollidiot‘. So etwas würde ich nie sagen. Aber jemand anderes vielleicht.“ Obama alias Peele fügt hinzu: „Das sind gefährliche Zeiten.“ Es bleibe uns nur, sehr vorsichtig zu sein bei dem, was im Internet als angebliches Zitat herumgehe. Und besonders wichtig sei es, gute Nachrichtenquellen zu haben, denen man vertrauen könne.

Ein „Hase-Video“ aus Chemnitz – echt oder Fake?

Was dank Digitaltechnik bereits an Filmmanipulation möglich ist, sehen wir seit vielen Jahren in Hollywood-Filmen: Bei teuren Produktionen ist es mittlerweile selbstverständlich, dass in vielen Szenen über die Hälfte der sichtbaren Ebenen im Computer entstehen. Grüne Wände standen in Wirklichkeit dort, wo später am Computer das Meer, eine Stadt oder Menschenmassen hinzugefügt wurden. Dass fast niemand mehr diese Manipulation bemerkt, zeigt, wie einfach Menschen auch bei Nachrichten getäuscht werden können.

Aber die Täuschung geht auch in die andere Richtung: Wenn jemand argumentiert, Fälschungen in Videos seien heutzutage recht einfach, dann verlieren „Videobeweise“ immer mehr ihre Gültigkeit. Will etwa jemand mit einem Video, das er mit seinem Handy gemacht hat, beweisen, dass auf einer Demonstration Ausländer gehetzt und beleidigt wurden, kann niemand mehr hundertprozentig sicher sein, ob sich alles wirklich so zugetragen hat. So geschehen im September 2018 in Chemnitz.

Eine Videosequenz von der Demonstration ist besonders bekannt geworden. Darin ruft eine Frau einem Mann, der einen ausländisch aussehenden Mann hinterherrennen wollte, zu: „Hase, du bleibst hier!“ Dieses „Hase-Video“ sei höchstwahrscheinlich gefälscht, mutmaßte der damalige Verfassungsschutzpräsident Hans-Georg Maaßen, und sorgte damit für eine heftige Kontroverse. Denn wie er das so kurz nach Veröffentlichung des Videos so schnell sehen konnte, sagte er nicht. „Nach meiner vorsichtigen Bewertung sprechen gute Gründe dafür, dass es sich um eine gezielte Falschinformation handelt“, sagte Maaßen damals, der mittlerweile in den einstweiligen Ruhestand versetzt wurde.

An gefakten Videos könnte zum Beispiel eine Partei Interesse haben, die Menschen glauben machen möchte, dass ausländische Mitbürger irgendwo brutale Angriffe vorgenommen oder sich anderweitig danebenbenommen hätten. Ihrem eventuellen Ziel, Ressentiments besonders Ausländern gegenüber zu schüren, könnten solche „Beweisaufnahmen“ gerade in Zeiten des Internet dienlich sein. Wer weiß heutzutage noch, ob die angeblichen Bewegtbilder echt sind?

Foto-Manipulation ist seit Jahrzehnten möglich und hat sich mittlerweile weitestgehend in der Medienkompetenz der Bürger manifestiert. Die Foto-Fälschungen etwa der Bild-Zeitung, als sie auf einem Foto dem Grünen-Politiker Jürgen Trittin einen Schlagstock andichtete, den es nie gab, gehören zum kollektiven Gedächtnis. Vielen bekannt ist auch die Retuschierung eines Foto von Lenin aus dem Jahr 1920, bei dem die Kommunistische Partei zwei ehemalige Mitstreiter Lenins später herausretuschieren ließ.

Hollywood-Stars in fremden Rollen

Im Dezember 2017 machte ein Video im Internet die Runde, in dem die „Wonder Woman“-Hauptdarstellerin Gal Gadot in einem Porno zu sehen war. Ein Nutzer des Online-Portals Reddit hatte den Clip unter dem Pseudonym „deepfakes“ (ein Kofferwort aus „Deep Learning“ und „Fake“) veröffentlicht. Darin war das Gesicht der Israelin auf den Körper einer Pornodarstellerin gesetzt worden, und es sah täuschend echt aus. Die Technik dahinter: Der Programmierer hatte einen Algorithmus mit Pornovideos und tausenden Fotos und Videos von Gal Gadot gefüttert. Das Erstaunliche: Dahinter steckte lediglich ein ambitionierter gewöhnlicher Technik-Nerd, nicht etwa ein Software-Imperium oder ein Geheimdienst. „Mit ein paar Hundert Bildern von Gesichtern kann ich Millionen Vorlagen erstellen, um das Netzwerk zu trainieren“, sagte der Videokünstler gegenüber dem Technikmagazin Motherboard. „Wenn ich das Netzwerk danach mit einem neuen Gesicht füttere, denkt es, dass es eine weitere verzerrte Vorlage sieht, und versucht, es genau so wie das Trainings-Gesicht aussehen zu lassen.“

Es dauerte nicht lange, bis eine kostenlose „FakeApp“ im Internet zu haben war, mit der quasi jeder diese Zauberei nachmachen kann. Mittlerweile gibt es regelmäßig Videos im Netz, bei denen das Gesicht eines Prominenten durch das eines anderen ersetzt wurde. So hat in einem Video, das über 300.000 Mal angeklickt wurde, die junge Schauspielerin Jennifer Lawrence plötzlich das Gesicht ihres deutlich älteren Kollegen Steve Buscemi, oder Trump spricht mit dem Gesicht von Mr. Bean. Der KI-Forscher Alex Champanard sagte gegenüber Motherboard, dass man dafür nicht viel mehr als eine handelsübliche Grafikkarte und ein paar Tage Zeit bräuchte.

Videos galten bislang als vertrauenserweckend

Was bei prominenten Hollywood-Schauspielern noch lustig aussieht und niemandem wehtut, kann jedoch auch schnell ins Auge gehen. Ein enttäuschter Partner könnte sich mit einem „Deepfake“-Video an seinem oder ihrem Ex rächen. Einfach das Gesicht des anderen in ein Pornovideo montiert, und ein zukünftiger Arbeitgeber könnte die Fälschung nicht erkennen und Probleme bereiten. Das Technikmagazin c’t aus dem Heise-Verlag macht darauf aufmerksam: „So etwas wäre allerdings definitiv illegal: Nicht nur wegen des Rechts am eigenen Bild, sondern auch wegen der klaren Verletzung des Persönlichkeitsrechts. Wer unfreiwillig in peinlichen Videos landet, kann die Produzenten obendrein wegen Beleidigung, Verleumdung und übler Nachrede anzeigen – Deepfakes können also sogar strafrechtlich relevant sein.“

Experten warnen zudem vor einer noch brisanteren Dimension von „Deepfake“-Videos. Im Jahr 2016 beispielsweise wurde auf manchen Nachrichtenwebseiten die Meldung veröffentlicht, dass Israel Pakistan mit einem Atomschlag drohe. Was, wenn derartige Falschmeldungen in Zukunft mit einem Video versehen sind, in denen – scheinbar – ein hochrangiger israelischer Politiker tatsächlich vor laufender Kamera derartige Äußerungen macht? Wird die Meldung dann immer noch so schnell als Fake News entlarvt werden?

In heutiger Zeit werden Nachrichten und solche, die dafür gehalten werden, innerhalb von Minuten über den ganzen Globus an Millionen von Menschen verbreitet. Bislang galten Videos noch als eher verlässliches Zeichen für die Echtheit einer Meldung. Hatte jemand ein Video von einem Ereignis gemacht, muss es wohl wirklich so passiert sein … Laut einer Studie im Auftrag des WDR aus dem Jahr 2018 bringen 64 Prozent der Bürger dem öffentlich-rechtlichen Rundfunk sehr großes Vertrauen entgegen, den Tageszeitungen hingegen nur 55 Prozent. Quellen im Internet halten nur 30 Prozent für glaubwürdig. Und wenn es um das Informieren über das politische Geschehen geht, bevorzugen fast doppelt so viele Menschen das öffentlich-rechtliche Fernsehen (65 Prozent) gegenüber dem Internet (35 Prozent).

Der Filmemacher und Video-Experte Alan Melikdjanian ist bei YouTube ein Held. Als solcher tritt er in seinen Videos auch auf. In bester Superhelden-Manier taucht er auf, wenn irgendwo im Internet wieder einmal ein Video die Runde macht, das zwar alle Leute staunen macht, aber nichts weiter als das Produkt eines talentierten Animations-Genies ist. Unter dem Namen „Captain Disillusion“ klärt Melikdjanian genau darüber auf, wie ein angebliches Sensationsvideo gemacht wurde und woran man es erkennen kann. Über 1,4 Millionen Menschen haben seinen YouTube-Kanal abonniert, und die Videos werden millionenfach angeklickt. Es spricht sich herum, dass mittlerweile auch bewegten Bildern nicht mehr ganz zu trauen ist.

Wir müssen umdenken!

Tatsächlich verstehen auch immer mehr staatliche Behörden den Trend. Das Verteidigungsministerium der Vereinigten Staaten etwa hat unter dem Dach der „Defense Advanced Research Projects Agency“ (DARPA) ein Projekt für „Medien-Forensik“ ins Leben gerufen. „Unsere Software soll sich ein Bild oder ein Video ansehen und dann sagen, ob es digital oder auf andere Weise manipuliert wurde“, sagte der zuständige Informatiker Matt Turek in einem Interview der Süddeutschen Zeitung. Das Projekt mit dem Namen „Metaphor“ wurde 2016 gegründet und arbeitet im Grunde so ähnlich wie „Captain Disillusion“: Wenn einige Pixel in einem Videobild plötzlich unerwartet auftauchen und an dieser Stelle nicht mehr mit dem Bereich im vorherigen Bild übereinstimmen, ist das verdächtig.

„Diese subtilen Anzeichen können Menschen nicht erkennen“, sagte Turek, „aber es ist relativ einfach für automatisierte Systeme.“ Einige Details könne aber auch ein geübter Beobachter selbst herausfinden, sagte Turek: „Passen die Schatten im Bild zu den Lichtquellen? Passt die Geometrie der gezeigten Szene zu dem, was wir über die benutzte Kamera wissen?“ Auf einer weiteren Ebene könne der Betrachter semantische Informationen, die das Video vermittelt, mit dem abgleichen, was man sonst über das Geschehen weiß. Wenn ein Video etwa an einem bestimmten Ort zu einer bestimmten Zeit gemacht wurde, kann man nachschauen, wie das Wetter zu diesem Zeitpunkt war, und dies mit dem Wetter im Video vergleichen. Turek ist sich sicher: „In der Zukunft werden die Menschen eine andere Einstellung zu Videos und Fotos haben. Sie werden ihnen weniger vertrauen.“ Und auch er weiß: Filme manipulieren können mittlerweile halbwegs talentierte Hacker von zu Hause aus. Und damit eventuell die Weltpolitik verändern.

Jeder sollte sich der technischen Möglichkeiten in Foto- und Videomanipulation bewusst sein. Selbst wenn man selbst nicht wissen muss, wie genau die Manipulation am Schnittarbeitsplatz oder mit einer Handy-App vor sich geht: Es reicht zu wissen, dass täuschend echte Manipulation möglich ist. Denn nur so bleibt eine gesunde Skepsis erhalten, wenn man die Nachrichten im Fernsehen oder angeblich wackelige Handy-Videos im Internet sieht.

Dieser Text erschien zuerst in der Ausgabe 3/2019 des Christlichen Medienmagazins pro. Sie können die Zeitschrift kostenlos und unverbindlich bestellen unter der Telefonnummer 06441/5667752, via E-Mail an info@pro-medienmagazin.de oder online.

Von: Jörn Schumacher